Judging Truth

Brashier, N. M., & Marsh, E. J. (2020). Judging truth. Annual review of psychology, 71(1), 499-515. https://doi.org/10.1146/annurev-psych-010419-050807

Abstract des auteur·trice·s

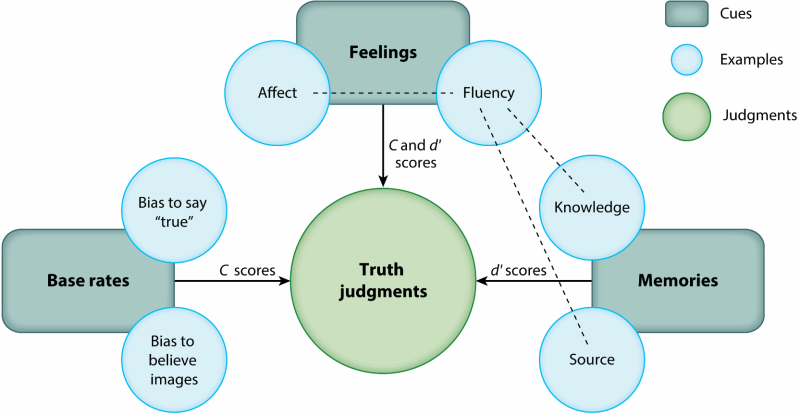

Deceptive claims surround us, embedded in fake news, advertisements, political propaganda, and rumors. How do people know what to believe? Truth judgments reflect inferences drawn from three types of information: base rates, feelings, and consistency with information retrieved from memory. First, people exhibit a bias to accept incoming information, because most claims in our environments are true. Second, people interpret feelings, like ease of processing, as evidence of truth. And third, people can (but do not always) consider whether assertions match facts and source information stored in memory. This three-part framework predicts specific illusions (e.g., truthiness, illusory truth), offers ways to correct stubborn misconceptions, and suggests the importance of converging cues in a post-truth world, where falsehoods travel further and faster than the truth.

Summary Points

- In everyday life, accurate claims outnumber inaccurate ones. People exhibit a bias to accept incoming information (i.e., judge claims to be “true”) that reflects these base rates.

- Subjective feelings convey useful information about the world. Thus, we infer truth from feelings like easy processing and our own affect

- Relevant facts and memories about the source of a claim can be completely diagnostic of the truth. As a result, people believe statements that match information retrieved from memory and reject inconsistencies.

- Considering these three classes of inference – from base rates, feelings, and consistency – can improve approaches to correcting misconceptions.

Introduction

Pour elles, il y a des informations qui "feel false" et d'autres qui "feel true". Quelques exemples:

- A camel's hump stores water. (faux)

- Albert Einstein failed math in school (faux)

- Suicide rates peak during the holidays (faux)

- An octopus has three hearts (vrai)

- Anne Frank and Martin Luther King, Jr. were born in the same year (vrai)

- The unicorn is Scotland's national animal (vrai)

Avec cet article, les autrices couvrent le processus pour déterminer les "false claims" (fausses déclarations) ; c'est-à-dire si les gens pensent que l'information est objectivement vraie ou fausse (donc pas ce qui touche aux attitudes et à la persuasion).

The construction of truth

Les jugements de vérités sont "construits" ; ils sont basés sur des heuristiques. Elles identifient 3 bases pour les jugements de vérité:

- inferences from base rates (les gens ont des suppositions de "probabilité a priori")

- inferences from feelings (lié à la feeling-as-information theory)

- inferences from consistency with existing knowledge

D'un point de vue bayésien, il est assez "logique" de considérer qu'une information facile à traiter est "vraie" (étant donné qu'on a plutôt accès des informations vraies).

Chacun de ces types d'inférences ont leurs erreurs spécifiques (se baser sur le base rate peut rendre crédule, s'appuyer sur les émotions peut pousser à considérer des choses "agréables" comme vraies, et se baser sur la consistance peut limiter la mise à jour de ses connaissances).

Inferring truth from base rates

Les gens ont plutôt tendance à juger une nouvelle information comme "vraie". Ce réflexe a du sens du point de vue bayésien ; étant donné les éléments nouveaux dans la vie quotidienne ont tendance à être vrais. Le jugement pourra être mis à jour plus tard. Gilbert (1999) dit même que, pour être comprise, une information a besoin d'être d'abord représentée comme vraie (et elle pourra être, dans un 2e temps, rejetée comme fausse).

Le processus de "décroyance" (unbelieving) nécessite un effort cognitif, ce qui fait que ce processus est vulnérable à la distraction. Par exemple, l'expérience de Gilbert, Krull, & Malone, 1990 montre que les personnes, lorsqu'elles étaient dérangées pour émettre un jugement de vérité (en l'occurrence, réaliser une action parasite pendant qu'elles devaient juger des phrases apprises précédemment), avaient tendance à juger des éléments faux comme "vrai", mais pas le contraire (i.e. juger des élément vrais comme "faux"). Dans leurs études précédentes, les autrices ont montré que les gens ont, par défaut, légèrement tendance à considérer une affirmation nouvelle comme "plutôt vraie".

Les individus utilisent souvent des images pour évaluer la véracité des informations, car la majorité des éléments visuels rencontrés dans la vie quotidienne sont réels. Les photos retouchées peuvent engendrer de faux souvenirs, comme des souvenirs d'événements qui n'ont jamais eu lieu. Une étude a révélé que les affirmations accompagnées de photos, même sans preuves concrètes, sont perçues comme plus vraies. Cette tendance à croire aux éléments visuels persiste même inconsciemment, rendant difficile pour les gens de reconnaître cette influence. En outre, des images, qu'elles soient réalistes ou manipulées, augmentent la propension des utilisateurs à partager des informations sur les réseaux sociaux, qu'elles soient véridiques ou non.

D'un point de vue bayésien, il est logique de considérer une image comme vraie (ce qu'on voit de nos yeux l'est généralement). Cela dit, Newman et collègues (2015) ont montré que des incohérences texte-image ont tendance à réduire l'effet de Truthiness, voire même, à avoir un effet inverse.

Inferring truth from feelings

Illusory truth

Les gens utilisent des heuristiques pour déterminer si les choses sont vraies ou non. Un effet qui a un fort impact sur le jugement de vérité est l'illusory truth effect (effet de vérité illusoire): plusieurs études montrent que des phrases répétées sont plus jugées "vraies" que des phrases nouvelles. Selon une méta-analyse de plus de 50 études, la vérité illusoire est un effet moyen (d de Cohen = 0,39-0,49). Cette estimation est peut-être sous-évaluée, car la plupart des chercheurs indiquent aux participants qu'ils seront confrontés à des informations vraies et fausses. La suppression de cet avertissement double l'effet de la répétition. Une seule exposition peut suffire, et l'effet de vérité illusoire peut avoir un impact même plusieurs mois plus tard. La lecture d'affirmations contradictoires peut augmenter l'effet. Par exemple, la phrase « Les crocodiles dorment les yeux ouverts » suivie une semaine plus tard, de la phrase « Les crocodiles dorment les yeux fermés » semble plus vraie que des nouvelles informations. Les gens oublient les détails de l'affirmation initiale et basent plutôt leur jugement sur la facilité avec laquelle ils peuvent traiter les concepts clés (par exemple, crocodiles, sommeil). On peut avoir un effet de vérité illusoire aussi sans répétition: par exemple, un texte qui rime semblera plus vrai qu'un texte qui ne rime pas ; aussi, un texte lu par un·e natif·ve aura l'air plus vrai que prononcé avec un accent.

L'illusion de vérité reflète une expérience métacognitive "relative": l'effet est plus marqué lorsque des listes mélangent des déclarations nouvelles et répétées. Contrairement à ce que l'on pourrait attendre, les participants n'écartent pas automatiquement les éléments répétitifs, même lorsqu'ils sont confrontés à des manipulations évidentes. Bien qu'ils puissent expliquer la fluidité lors de l'évaluation de la préférence ou de la fréquence, cela ne se produit pas lorsqu'ils jugent la vérité. Les participants non seulement se souviennent des affirmations précédemment vues avec une précision supérieure à 90%, mais l'effet est si fort qu'ils ne tiennent pas compte des avertissements contre la vérité illusoire.

En réalité, cet effet est "mal-nommé" ; Schwarz parle de "wisdom in feelings" plutôt. Par ailleurs, c'est une heuristique pertinente en raison de la corrélation naturelle entre fluidité et vérité dans la vie quotidienne. En général, on entend la version vraie d'une affirmation plus souvent que ses diverses fausses versions, ce qui permet d'associer rapidement fluidité et justesse du jugement.

Emotions and illusory truth

Les émotions influencent considérablement nos jugements. L'humeur (influencée par des facteurs comme la météo) est également liée à des résultats concrets, tels que l'admission en faculté de médecine ou les rendements boursiers. De plus, le traitement de l'information perçu comme facile est associé à des sensations positives. Par exemple, les visages récemment vus semblent plus heureux et les visages souriants apparaissent comme plus familiers.

Unkelbach et collègues (2011) ont étudié si l'illusion de vérité était simplement liée à la positivité en faisant évaluer des affirmations statistiques avec des cadrages positifs (comme "Le taux de divorce à Grenade est inférieur à celui du reste de l'Espagne") et négatifs ("Le taux de divorce à Grenade est supérieur à celui du reste de l'Espagne"). L'illusion de vérité s'est manifestée pour les deux types d'affirmations (ce qui confirme que la fluidité est le moteur du jugement). Cependant, les affirmations suscitant des sentiments plus positifs semblaient également plus crédibles, ce qui indique que la positivité avoir une influence de manière indépendante.

En revanche, la tristesse détruit l'effet de l'illusion de vérité, comme le montre une étude où des affirmations étaient jugées tout aussi vraies, indépendamment de la lisibilité, après le visionnage de vidéos tristes. De plus, une humeur négative semble augmenter la capacité à déceler la tromperie, tandis que les gens jugent les affirmations comme plus fiables lorsqu'elles apparaissent à côté d'un visage neutre plutôt que d'un visage en colère ou apeuré. En résumé, un mauvais moral peut décourager les gens de suivre leur intuition.

Inferring truth from consistency with memory

Un modèle rationnel des jugements de vérité suppose qu'un individu considère une information comme vraie quand elle correspond aux informations stockées en mémoire (sémantique pour les faits pertinents, et épisodique pour des détails concernant la source). On utilise nos connaissances pour résoudre des ambiguités, mais aussi pour prédire le futur. On a tendance à accepter les faits cohérent avec ce qui est en mémoire, et rejeter ce qui ne correspond pas.

On a assez tendance à négliger les mensonges qui ressemblent à la vérité, car des erreurs sont fréquentes dans le langage courant. Les messages n'ont pas besoin d'être entièrement vrais, mais seulement "suffisamment bons", ce qui conduit les gens à accepter des correspondances partielles entre les déclarations et les contenus de leur mémoire.

La fluidité entrave notre capacité à détecter les incohérences, car les gens remarquent moins d'erreurs lorsque les questions sont "fluides" à lire (p.ex.: "Combien d'animaux de chaque espèce Moïse a-t-il pris dans l'arche ?"). De plus, la répétition rend des contradictions de faits connus plus crédibles, même si intuitivement, cela ne devrait pas être le cas. Contrairement à ce qu'on pense, la connaissance ne protège contre l'effet de vérité illusoire. Des études ont confirmé que même des affirmations contraires à des faits connus (p.ex.: "Newton a proposé la théorie de la relativité") voient leur crédibilité accrue par la répétition. Ainsi, les jugements de vérité de fausses affirmations augmentent, indépendamment de la connaissance que les individus ont de ces faits.

Contrairement au modèle conditionnel basé sur la connaissance, qui suggère que la fluidité n'intervient que lorsque les individus manquent d'informations, leurs résultats montrent que la fluidité peut influencer les jugements même lorsque les gens ont une bonne compréhension du sujet. En effet, la répétition peut accroître la croyance en des affirmations implausibles, telles que "Fumer des cigarettes est bon pour les poumons" ou "La Terre est un carré parfait". Par conséquent, l'éducation constitue une solution partielle à la crise de la désinformation, car les individus peuvent apprendre de nouveaux faits tout en continuant à ignorer ou à contredire ces connaissances.

L'effet de vérité illusoire est indépendante des différences individuelles en matière d'intelligence fluide et de style cognitif. Par exemple, l'intelligence fluide décline chez les personnes âgées, mais ces dernières peuvent être tout aussi, voire plus, capable de discernement que les jeunes. La répétition d'affirmations obscures, comme "smallest insect species is the adelgid", induit une confusion similaire chez les jeunes et les personnes âgées. Cependant, les adultes plus âgés ont tendance à s'en tenir à ce qu'ils savent et rejettent des affirmations incorrectes, même lorsqu'elles semblent fluide. Ils prennent également plus de temps pour évaluer la véracité, ce qui pourrait leur conférer des avantages en ralentissant leur processus de jugement.

Considérer attentivement les affirmations peut être bénéfique dans certaines situations, mais peut aussi être contre-productif dans d'autres. Dans une expérience sur les niveaux de traitement, des participant·e·s ont évalué des affirmations de manière superficielle, profonde, ou en les reliant à des événements personnels, et ont ensuite jugé leur véracité. Surprenammant, la vérité illusoire a augmenté avec la profondeur de l'encodage. Le traitement élaboratif n'a pas inversé l'effet de vérité illusoire, mais l'a en réalité renforcé. Une approche plus efficace consisterait à encourager les participants à agir comme des "fact checkers". Dans nos études, le fait de se concentrer initialement sur la précision éliminait l'effet de vérité (seulement lorsque les participant·e·s disposaient de connaissances pertinentes en mémoire). Sans cette connaissance, iels retombaient sur la fluidité, indépendamment de la manière dont iels avaient traité les affirmations au départ.

Tout comme les connaissances stockées, la mémoire épisodique (expériences passées spécifiques) sert de base pour évaluer la vérité. Par exemple, se rappeler qu'une affirmation provient d'une source peu crédible est informatif. Ainsi, une expérience montre que des déclarations entendues d'une voix jugée "non fiable" semblent moins vraies que des nouvelles. Ce phénomène appuie une théorie référentielle de la vérité, où la crédibilité perçue d'une affirmation correspond à celle de sa source, augmentant ainsi la "perception de vérité".

Les gens ont des difficultés à évaluer la qualité des sources, s'appuyant souvent sur des raccourcis tels que la présence de citations dans le texte ou la répétition. Nous avons également tendance à faire confiance aux autres, même à des étrangers ; ce peut être un problème lorsque les gens veulent partager des fake news. De plus, même en prenant conscience qu'une source est douteuse, les individus oublient souvent ces détails épisodiques. En l'absence d'un encodage rétrospectif soutenu par l'activité dans l'hippocampe et le cortex préfrontal ventrolatéral, des affirmations initialement marquées comme "fausses" peuvent sembler crédibles plus tard. Une fois que les gens échouent à se souvenir si une déclaration provient d'une source fiable, ils se fient à la fluidité pour tirer des conclusions.

Ignorer ses connaissances ou oublier les informations est un grand problème à l'ère numérique. La recherche sur Google nous pousse à rechercher des réponses à des questions simples plutôt que de les récupérer de leur mémoire. Cependant, les algorithmes de recherche renvoient du contenu basé sur des mots-clés, plutôt que sur la véracité (p. ex.: une recherche sur la Terre plate peut donner des résultats mensonger). Par ailleurs, les gens partagent souvent des articles sans les avoir lus: 59 % des liens partagés sur Twitter ne sont pas consultés au préalable (Gabielkov, Ramachandran, Chaintreau, & Legout, 2016). Et même lorsque les lecteur·trice·s lisent effectivement l'article, on peut avoir de la désinformation qui induit les lecteur·trice·s en erreur.

Summary

C'est un article qui pioche dans différentes approches pour voir comment les gens construisent un modèle de vérité. Pour elles, les individus s'appuient sur des base rate, ce qui améliore la précision générale, mais peut également augmenter la crédulité. Ils interprètent des expériences subjectives, telles que la fluidité du traitement et les éléments affectifs, comme des preuves (des sentiments qui corrèlent parfois avec la vérité mais pas toujours). De plus, ils infèrent des jugements basés sur la cohérence avec les informations stockées en mémoire. Bien que les connaissances stockées et les souvenirs de source soient potentiellement indicatifs de la vérité, les gens ont souvent tendance à les négliger, à se tromper ou à les oublier.

Ces inférences ont des répercussions dans le monde réel, où la désinformation entraîne des problèmes comme des épidémies (par exemple, des flambées de rougeole dues aux campagnes anti-vaccins), nuit à l'environnement (comme le braconnage lié aux mythes sur les cornes de rhinocéros) et favorise la violence (par exemple, contre des rumeurs sur des kinappeurs d'enfants sur WhatsApp).

Correcting misconceptions

L'idéal serait d'empêcher les idées fausses de s'installer dès le départ, car elles sont difficiles à corriger. Même lorsque les gens réussissent à rectifier des mythes à court-terme (comme l'idée qu'écouter de Mozart améliore l'intelligence des bébés), il est plus difficile de le faire sur le temps long. Le problème réside dans le fait que l'on stocke simultanément les informations erronées et leur correction (comme l'indiquent les activités dans le gyrus angulaire gauche et le précuneus bilatéral). De plus, la correction est oubliée plus rapidement que l'information fausse de base (puisqu'elle est plus ancienne, c.f. la loi de Jost).Par ailleurs, les messages de démenti touchent moins de personnes que la désinformation initiale ; par exemple, un article de Snopes qui a démenti l'affirmation selon laquelle Nancy Pelosi aurait accepté un mur à la frontière en échange d'une interdiction des armes a reçu presque 20 fois plus d'engagements sur Facebook que sa correction.

Elles proposent plusieurs angles pour corriger les "mésinformés": Premièrement, faire appel aux expériences des gens avec les "base rates". Aussi, ajouter des visuels aux corrections pour augmenter la fluidité et induire un effet de truthiness. Deuxièmement, les messages doivent éviter de renforcer les émotions associées aux mythes. Simplement nier la désinformation ou la présenter aux côtés de la vérité dans un format mythe-fait peut rendre l'affirmation fluide. De plus, les gens ne traitent plus difficilement les propositions sous leur forme "négative". Ainsi, un message bien intentionné comme "les vaccins ne causent pas l'autisme" peut renforcer l'idée d'un lien entre vaccins et autisme. Cependant, le conseil de remplacer plutôt que de répéter rend les corrections moins perceptibles, posant un défi lorsque la question reste débattue.

Un autre point d'accroche serait de tirer parti du désir des gens de cohérence entre leurs connaissances et leurs croyances. L'exposition à des points de vue opposés peut entraîner une polarisation des opinions plutôt qu'une modération. Une étude demandant d'évaluer la crédibilité de données médicales (e.g. les germes sont une cause principale de maladie), avant de juger la crédibilité des données sur le climat a montré que, étant donné que la croyance en la médecine dépasse celle en la science climatique, une fois qu'ils ont reconnu la valeur d'autres domaines scientifiques, les conservateurs étaient plus enclins à soutenir la science climatique.

Une autre possibilité serait d'utiliser la "disfluency" (i.e. le contraire de la fluency) pour inciter à une pensée analytique. Les gens ont souvent des réactions instinctives lorsque l'information va dans le sens de leurs opinions. En revanche, les personnes militantes qui réussissent bien au test de réflexion cognitive (i.e. les personnes plus "penseuses analytiques") sont en mesure de distinguer plus précisément de faux titres de vrais, même lorsqu'ils sont alignés avec leurs politiques. Une étude a montré que des participant·e·s lisant un essai favorable à la peine de mort dans une police facile ou difficile à lire jugeaient la fiabilité du message différemment. Après une lecture facile, leurs croyances personnelles influençaient leurs impressions, tandis que cette "préférence pour la cohérence" disparaissait après une lecture difficile. Par conséquent, présenter des mythes dans un format "disfluide" pourrait aider les gens à mettre de côté leurs opinions.

Enfin, le conseil courant de prendre en compte la source des informations est souvent mal orienté. Les efforts des fact cherckers pour signaler des affirmations virales peuvent avoir des effets contre-productifs ; par exemple, marquer certaines fake news comme fausses peut augmenter la perception d'exactitude des histoires non étiquetées. Une meilleure solution consiste à utiliser des jugements collectés sur la fiabilité des sources, qui se sont révélés précis, et qui pourraient servir d'entrées aux algorithmes de classement des réseaux sociaux. Cependant, la censure ou la manipulation de contenu pourrait susciter la colère des utilisateurs.

Conclusion

Gartner, Inc. estime qu'en 2022, les gens consommeront plus de fausses informations que de vérités, une perspective inquiétante qui s'aligne avec les tendances actuelles sur les réseaux sociaux, où les fausses informations dépassent déjà la vérité sur Twitter. Si la fluidité ne corrèle plus naturellement avec la vérité, vers quels autres indices les gens se tourneront-ils ? Les psychologues ont beaucoup étudié la fluidité, qui façonne la perception de la vérité sur le long terme, même chez les personnes intelligentes, malgré des connaissances contradictoires et pour des affirmations provenant de sources jugées "non fiables". Cependant, la fluidité n'est qu'un moyen d'inférer la vérité ; les gens s'appuient également sur d'autres ressentis, des fréquences de base, et la cohérence avec ce qu'ils savent, se souviennent et croient.

Les modèles multinomiaux actuels opposent deux processus cognitifs. Par exemple, Unkelbach et Stahl (2009) ont montré que les gens s'appuient sur la fluidité lorsqu'ils oublient des informations sur la source. Dans leur fluency-conditional model, elles se focalisent aussi sur deux processus et supposent que les gens recherchent des connaissances pertinentes lorsqu'ils éprouvent de la "disfluence". Cala dit, ces modèles offrent peu d'insights sur les situations où de nombreux indices convergent. Par exemple, chez un concessionnaire automobile, un acheteur pourrait rencontrer des slogans familiers, des photos, des faits sur l'économie de carburant, des informations sur les motivations du vendeur, et ressentir de l'excitation. Comment évaluent-ils la véracité des déclarations concernant une voiture et décident-ils finalement de l'acheter ? Si les chercheurs prennent en compte des indices multiples et simultanés, des heuristiques supérieures pourraient apparaître. Par exemple, le client pourrait peser tous les indices de manière égale ou se fier à un seul bon raisonnement, tel que ses propres émotions, tout en ignorant d'autres indices. Réduire l'information peut être particulièrement tentant, surtout sous distraction ou chez les adultes plus âgés, qui préfèrent moins d'options lors de la prise de décision. À l'avenir, le domaine doit prendre en compte les processus cognitifs, affectifs et sociaux qui rendent les fausses informations crédibles dans un monde post-vérité.